Simon Willison baru-baru ini merilis plugin baru bernama llm-hacker-news untuk alat LLM berbasis command-line miliknya, yang dirancang untuk mengambil konten dari diskusi Hacker News dan menyalurkannya langsung ke model bahasa besar. Sementara pencapaian teknis ini mengesankan banyak orang, hal ini juga memicu perdebatan signifikan tentang privasi data, persetujuan, dan etika penggunaan konten forum publik untuk pemrosesan AI.

Inovasi Teknis

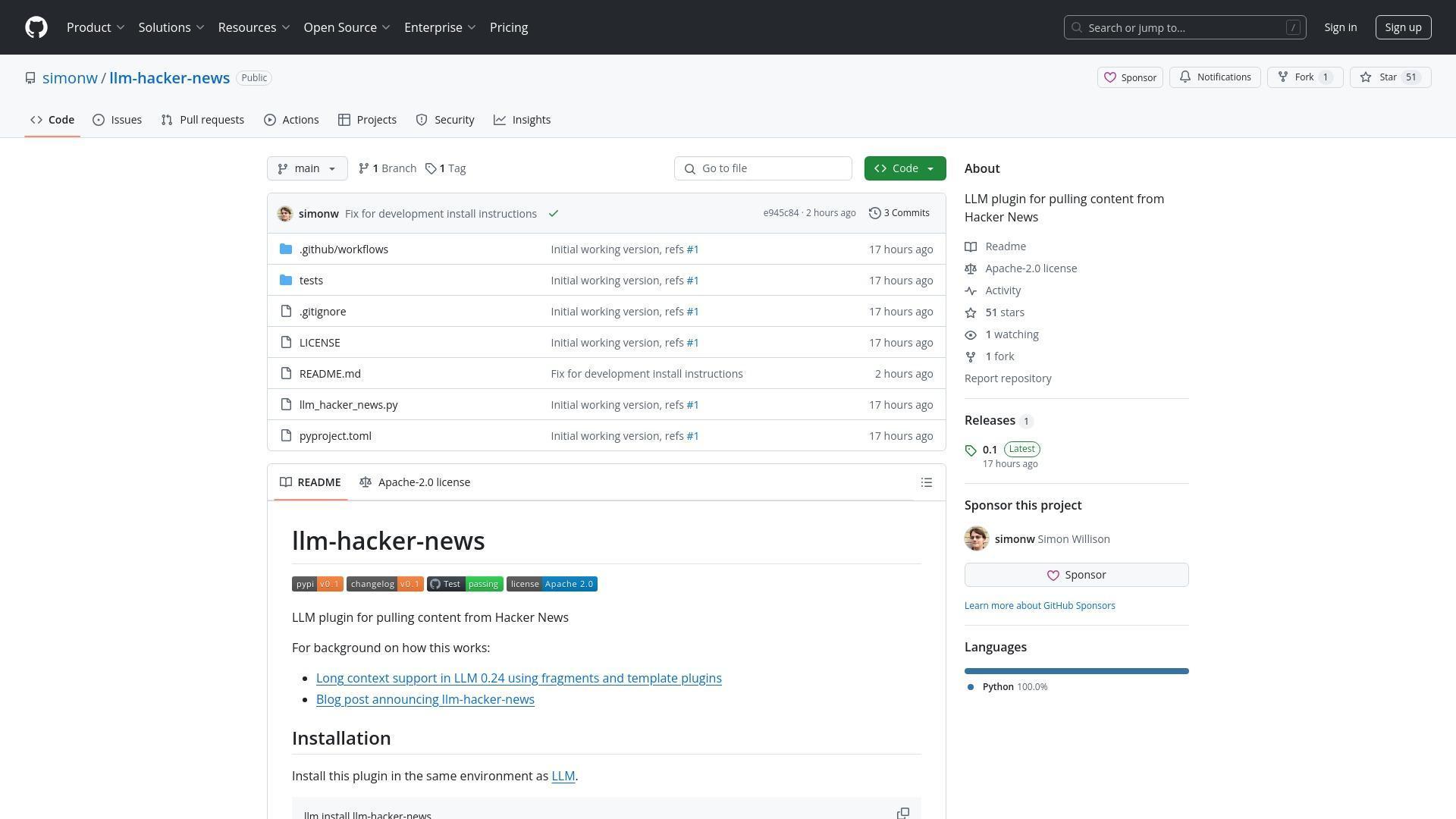

Plugin llm-hacker-news dibangun berdasarkan fitur fragments baru yang ditambahkan Willison ke alat command-line LLM miliknya. Fitur ini memungkinkan pengguna dengan mudah memasukkan konten konteks panjang ke dalam model bahasa besar seperti Gemini dan Llama 4. Plugin ini secara khusus memungkinkan pengguna untuk mengambil seluruh thread diskusi Hacker News menggunakan sintaks perintah sederhana:

llm -f hn:43615912 'summary with illustrative direct quotes'

Plugin ini mengambil data dari API Hacker News, mengubahnya menjadi format teks yang ramah LLM, dan mengirimkannya ke model default yang dikonfigurasi pengguna (seperti gpt-4o-mini). Ini menyederhanakan proses analisis dan perangkuman diskusi online tanpa perlu menyalin dan menempelkan secara manual.

Fitur Utama plugin llm-hacker-news:

- Memungkinkan pengambilan seluruh thread Hacker News menggunakan ID item

- Dibangun berdasarkan fitur baru "fragments" dalam alat command-line LLM

- Menggunakan Algolia JSON API untuk mengambil konten

- Mengkonversi konten HN menjadi format teks yang ramah LLM

- Bekerja dengan berbagai model LLM termasuk GPT-4o-mini, Claude, dan Gemini

Instalasi dan Penggunaan:

llm install llm-hacker-news

llm -f hn:43615912 'summary with illustrative direct quotes'

Kekhawatiran Komunitas Terkait:

- Privasi data dan persetujuan untuk pemrosesan konten

- Kepatuhan terhadap Ketentuan Layanan

- Perbedaan antara pembacaan oleh manusia vs pemrosesan algoritmik

- Masa depan kepemilikan konten di internet yang didukung AI

Kekhawatiran Privasi dan Persetujuan

Peluncuran ini memicu diskusi hangat tentang apakah pengguna harus dapat memilih untuk tidak menyertakan posting forum mereka diproses oleh LLM. Seorang pengguna bertanya langsung: Apakah ada cara untuk memilih agar percakapan saya tidak disalurkan ke LLM? Pertanyaan ini mencerminkan kekhawatiran yang semakin besar tentang pengambilan konten dan hak penggunaan.

Kekhawatiran di sini adalah bahwa orang-orang tidak senang bahwa parasit LLM membuang-buang bandwidth mereka dan karenanya uang mereka pada skema untuk menjadi kaya dari hasil kerja orang lain.

Willison menanggapi dengan menunjukkan ketidakmungkinan praktis untuk mencegah tindakan salin-tempel, mencatat bahwa meskipun ada pembatasan seperti itu, tangkapan layar bisa menghindarinya. Dia juga menyoroti lanskap kompleks kebijakan pelatihan LLM, di mana beberapa penyedia seperti OpenAI dan Anthropic tidak melatih pada konten yang dikirimkan melalui API, sementara yang lain seperti Gemini mungkin menggunakan data dari pengguna tingkat gratis untuk meningkatkan produk.

Batas Hukum dan Etika

Beberapa komentator mengangkat pertanyaan tentang apakah plugin tersebut melanggar ketentuan layanan Hacker News, yang melarang scraping dan pengumpulan data. Satu pengguna secara khusus mengutip pedoman HN: Kecuali secara tegas diizinkan oleh Y Combinator, Anda setuju untuk tidak memodifikasi, menyalin, membingkai, mengikis, [...] atau membuat karya turunan berdasarkan Situs atau Konten Situs.

Diskusi tersebut mengungkapkan ketegangan mendasar antara aksesibilitas publik dan kepemilikan konten. Sementara beberapa berpendapat bahwa memposting di forum publik secara implisit menyetujui berbagai bentuk konsumsi, yang lain berpendapat bahwa ada perbedaan bermakna antara pembacaan manusia dan pemrosesan algoritmik, terutama ketika pemrosesan itu mungkin akhirnya masuk ke dalam dataset pelatihan AI komersial.

Masa Depan Alat LLM

Terlepas dari kontroversi, banyak pengguna menyatakan ketertarikan pada potensi teknologi ini. Permintaan untuk fungsionalitas yang diperluas termasuk merangkum topik favorit di HN, melacak diskusi dari waktu ke waktu, dan integrasi dengan protokol lain seperti MCP (Message Context Protocol). Willison menyebutkan bahwa fitur LLM besar berikutnya adalah dukungan alat, dengan rencana untuk membangun plugin MCP di atas kerangka kerja tersebut.

Diskusi ini juga menyentuh kualitas model LLM lokal yang meningkat pesat. Willison mencatat bahwa model lokal sebagian besar lemah dan tidak dapat digunakan sampai sekitar enam bulan yang lalu tetapi baru-baru ini menjadi jauh lebih mampu, dengan model seperti Qwen Coder 2.5, Llama 3.3 70B, Mistral Small 3, dan Gemma 3 sekarang berkinerja mengesankan pada perangkat keras konsumen dengan RAM yang memadai.

Plugin llm-hacker-news mewakili kemungkinan teknis yang menarik dan pertanyaan etis kompleks yang muncul ketika alat AI menjadi lebih terintegrasi dalam pengalaman online kita. Seiring teknologi ini terus berkembang, komunitas perlu menavigasi keseimbangan antara inovasi dan menghormati agensi pengguna serta hak konten.

Referensi: Ilm-hacker-news